北京飞搜科技斩获CVPR2018家具分类识别竞赛冠军

随着最后一届ImageNet(目前世界上图像识别最大的数据库)竞赛在2017年落下帷幕,本年度图像分类领域最高水平的比赛易主为由码隆科技联合Google Research 和美国知名电商 Wish联合举办的、针对家具家居领域的细粒度图像分类竞赛 iMaterialist Challenge (Furniture)。

竞赛力求推动自动图像分类顶尖技术的进展,所有参赛项目在 Kaggle 平台上进行评测。同时,作为CVPR2018(2018年度国际计算机视觉与模式识别学术会议)重要的研讨会之一,针对该比赛召开的 FGVC5 workshop(细粒度图像识别研讨会)将于6月22日与大会同期举行。

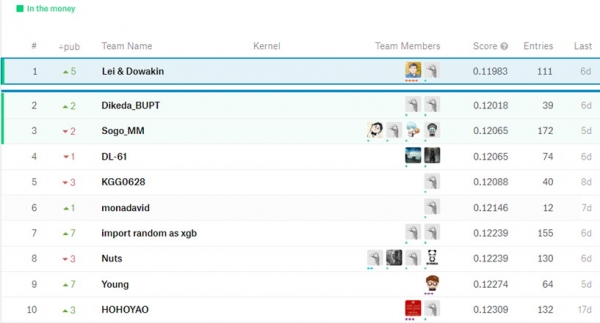

比赛要求对128类家具进行识别分类,共有436支队伍参赛,最终来自北京飞搜科技的李磊团队在北京邮电大学教授董远的指导下,以绝对优势获得冠军。

与 ImageNet 的粗粒度分类竞赛相比,本次竞赛更强调“在‘人造物体’领域的图像细粒度分类挑战”。一方面,这部分图像分类的技术难度更大,即便对于经过专业训练的人眼来说,也难以快速且准确地辨认很多细粒度分类数据集;另一方面,这种图像分类技术的应用前景更加广阔,可以应用于工业生产进程之中,提高效率、减少成本。

赛后,北京飞搜科技技术总监熊风烨分享了李磊团队在竞赛中使用的方法:李磊团队的识别算法主要基于CNN(卷积神经网络),针对给定的数据集,他们选择了在ImageNet上准确率较高的几种模型进行Finetune(就是用别人训练好的模型,加上自己的数据,来训练新的模型),并充分考虑了模型的差异性,以Pytorch框架为基准对其进行训练。在训练过程中,他们加入多项数据增强过程,采用SGD算法进行精细化调优参数,把全连接层的学习率设置为其他层的10倍,从而更好地调优全连接层。而对于SENet等较大的网络,则选择在SGD算法上升缓慢的时候转而使用Adam算法作为过渡。最终飞搜科技团队的单模型最好的识别效果是SENet在验证集上达到87.2%的准确率,而其他模型均有85.6%以上的表现。在测试过程中,飞搜科技团队采用了测试时数据增强的方案,采用12次增强,包括Ten crop加上原图及水平翻转图。对每个模型都得到以上12个结果的概率值进行存储,最后经过几何平均获取每个类别的准确率,取出得分最高的作为最后输出。实验证明几何平均往往在基数较大时能取得优于算术平均的效果。为了进一步减小识别可能带来的误差,飞搜团队还考虑了训练数据分布不均的情况,在测试时从贝叶斯角度加了一个校准,使得预测结果分布更均衡。

北京飞搜科技(http://www.faceall.cn/)专注于人工智能,计算机视觉和深度学习的研发,并把研究成果应用到城市运营中,让城市更加安全,交通更加高效,生产更加智能、购物更加方便。作为全球领先的深度学习技术提供商,北京飞搜科技是国家高新技术企业、中关村高新技术企业、北京市软件企业。公司不但提供智慧城市解决方案,还通过阿里云,华为云,amazon平台, 为企业与个人提供人脸/图像识别的SAAS服务; 离线SDK技术授权服务等, 到目前为止, 公司已经服务了200多家客户,为他们提供视频监控、智能鉴黄、人脸识别、图片识别、无人驾驶,线上购物支付、机器人等技术支持。

本次比赛斩获桂冠是对飞搜团队的技术水平和合作意识的一个十分有价值的肯定。北京飞搜科技公司也会借此契机继续前进,壮大团队,精进技术,更加自信地与全球精英角逐,在世界更高的舞台上为中国科技企业争光添彩!

来源:业界供稿

好文章,需要你的鼓励

OpenAI推出GPT Image 1.5模型加速图像生成竞争

OpenAI推出ChatGPT Images新版本GPT Image 1.5,承诺更好的指令遵循、更精确的编辑功能和高达4倍的图像生成速度。该模型面向所有ChatGPT用户和API开放。这是OpenAI在CEO奥特曼宣布"红色警报"后与谷歌Gemini竞争的最新升级。新模型提供后期制作功能,支持更精细的编辑控制,能在编辑过程中保持面部相似度、光照、构图和色调的视觉一致性,解决了传统AI图像工具迭代编辑时缺乏一致性的问题。

AI Institute杀手锏:用单元测试训练出超强文档识别神器,准确率飙升至82.4%

艾伦人工智能研究所开发的olmOCR 2通过创新的单元测试训练方法,将文档识别准确率提升至82.4%,在处理复杂数学公式、表格和多栏布局方面表现卓越。该系统采用强化学习和合成数据生成技术,实现了完全开源,为全球研究者提供了先进的OCR解决方案,推动了AI技术民主化发展。

Zoom推出AI Companion 3.0智能体工作流程

Zoom推出AI Companion 3.0,采用联邦AI架构结合自研模型与OpenAI、Anthropic等第三方大语言模型。新版本具备智能工作流、对话式工作界面等功能,可将会议对话转化为洞察、进度跟踪和文档内容。系统支持加密传输,不使用客户内容训练模型。用户可通过ai.zoom.us访问,或以每月10美元独立购买。

苹果公司发布Pico-Banana-400K:40万图片训练数据让AI修图像人类一样聪明

苹果公司发布了包含40万张图片修改案例的AI训练数据集Pico-Banana-400K,涵盖35种修图操作类型。该数据集采用严格质量控制,包含成功失败案例对比和多轮修图场景。研究显示AI在全局修改方面表现优秀,但精细操作仍有挑战。这为AI修图技术发展奠定基础,未来将让修图软件更智能易用。

Zoom推出AI Companion 3.0智能体工作流程

ChatGPT成为互联网最受阻止的爬虫机器人

英伟达推出开源权重模型填补美国AI市场空白

Meta推出SAM Audio模型:AI音频分离新突破

英伟达推动数据中心增长,以太网交换机销售创纪录

Quobyte推出GPU融合存储技术优化AI集群数据处理

泰恩港采用私有5G网络实现运营效率显著提升

艾伦人工智能研究所推出Molmo 2,为AI系统带来开放视频理解能力

Adobe Firefly新增基于提示词的视频编辑功能

对话AppsFlyer王玮:预算回升、格局收紧,“素材”成为新的竞争战场

NVIDIA Nemotron 3 系列开放模型: 击穿AI“工程墙”开启“Agentic AI”的“Linux时刻”

W.AWARDS金网奖2026未来商业计划领航秀峰会收官