氮化镓或将成为超快5G技术的关键

5G的出现,势必会带来对更高移动网络连接速度和更大数据容量的需求。为了应对这一提升性能的需求,就需要新的基站技术。

基站是所有移动网络必须克服的一个瓶颈。也正是这个瓶颈,将目前的4G网络限制在50Mbps的平均峰值数据速度内,并阻碍它实现真正的实时传输。

相反,5G或许能实现实时无线通信,并实现10Gbps的最大数据速率。

德国弗莱堡的弗劳恩霍夫应用固体物理研究所(Fraunhofer Institute for Applied Solid State Physics)声称拥有“扩大这一瓶颈的技巧”。

弗劳恩霍夫应用固体物理研究所研究人员目前正在开发新型功率放大器,能比当前4G技术以更快的速度发送更大量的数据。

这些新型功率放大器能利用高达6GHz的额外无线频率;相比之下,LTE则限定在2.7GHz。

但是,尽管这些高频率能实现更快的数据传输,同时却也更难有效地提供更高功率。

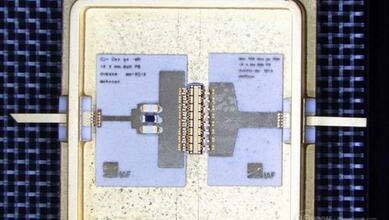

因此,劳恩霍夫IAF的科学家们开始利用氮化镓(GaN)构建更适合于更高5G频率的射频电源发送器。

劳恩霍夫IAF的Rüdiger Quay博士解释道:“由于氮化镓特殊的晶体结构,同样的电压可以在更高的频率中实现,从而带来更高的功率和更好的效率性能。”

加上能为用户提供高精确度数据服务的新型电子转向天线,5G网络能处理比当前高达200倍的数据传输量,而无需大幅度增加功率消耗。

好文章,需要你的鼓励

亚马逊推出Alexa网页版:生成式AI助手的新选择

亚马逊在CES期间宣布推出Alexa.com网站,用户可像使用其他AI聊天机器人一样与Alexa交互。经过数月早期体验,Alexa+已获得数千万用户。新网站支持语音和文本交互,需登录使用以确保跨设备功能连续性。76%的Alexa+交互为独特任务,包括智能家居控制和第三方集成。Alexa+兼容七年来的设备,正式版将收费每月20美元或包含在Prime会员中。

UCSD团队打造终极仿真世界:让AI智能体在虚拟城市中自立更生的惊人实验

SimWorld是由UCSD等多所顶尖院校联合开发的革命性AI仿真平台,基于虚幻引擎5构建了具备真实物理规律的虚拟城市环境。该平台支持无限扩展的程序化世界生成和自然语言交互,让AI智能体能够在复杂环境中学会生存、合作和竞争,为通用人工智能的发展提供了前所未有的训练平台。

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

AI笔记公司Plaud在CES 2026推出新款可穿戴设备NotePin S,可夹在衣领、戴在手腕或挂在脖子上记录对话。该设备通过蓝牙连接手机,配备双麦克风,录制范围约3米,支持一键高亮标记重要时刻。同时发布的还有Plaud Desktop桌面AI记录工具,可原生捕获线上会议内容,无需机器人加入通话。两款产品将所有笔记、会议和对话整合到统一平台管理。

浙江大学团队提出C2DLM:让AI推理更像人类思维的全新语言模型

浙江大学联合华为提出C2DLM,这是一种因果概念引导的扩散语言模型,通过自动提取因果关系并融入注意力机制来增强AI推理能力。相比传统方法,C2DLM在推理任务上平均提升1.31%-12%,训练效率提高3.2倍,为解决语言模型推理能力不足开辟了新路径。

MSI在CES 2026展示全新商务笔记本设计

英特尔Core Ultra 3处理器发布,游戏性能和续航大幅提升

HP新商务笔记本让IT部门更省心

AMD移动处理器获得显著性能提升

宏碁推出全新Swift Edge系列:更薄更坚固耐用

千问APP语音焕新,上线10款新音色更拟人

亚马逊推出Alexa网页版:生成式AI助手的新选择

Plaud推出可穿戴AI记录设备NotePin S,CES 2026记者新利器

机器人初创公司推出现实版瓦力机器人及其他伴侣产品

VisIC宣布完成2,600万美元B轮融资

CES 2026 | AMD扩张“边缘统治力” “芯片级异构”塑造汽车、工业边缘应用“新法则”

CES 2026 | NVIDIA新风向: Rubin平台面市 ,系统级“AI工厂”成型,物理AI加速落地