太一星晨应用交付:助力山西省“警务云”!

近几年来,在“科技强警”战略引领下,国内多地公安厅都陆续启动了“警务云”平台建设,旨在通过不断提升公安工作科技化、信息化水平,为打击犯罪、公正执法、服务群众提供有力支撑。 在系统架构层面,“警务云”平台依托基础设施服务平台、信息资源服务平台,并采用分布式计算的技术,实现公安信息资源的深度加工和挖掘。

在业务操作层面,“警务云”平台则表现为“民警在前台工作,后台一张网、一群大数据和多警种部门协同支持”的智能化工作模式。通过“警务云”平台,相关警务工作效率得到空前增长。特别是在进行排查工作的时候,通过云平台,由大数据、云计算中心集成相关数据库,只需几秒钟就可锁定目标——这无疑极大提升了案件的侦查能力。

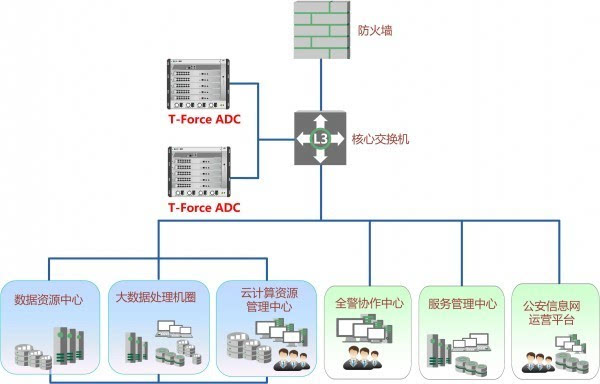

不过,由于省一级的“警务云”平台每天需要处理的业务量繁杂而庞大,且要面临大数据、大访问量的冲击,因此要保障“警务云”平台高效稳定地运行,整个系统架构还需要部署强有力的负载设备。由国内知名应用交付厂商太一星晨为山西省公安厅“警务云”平台部署的T-Force V系列应用交付设备,便在保障系统高效可靠的运行方面发挥了重要作用。

化解难点 将负载设备架设到云上

在传统的网络平台架设负载均衡产品,已经是一件驾轻就熟的事情,但要将负载均衡架设在云平台上,却并不容易。

云数据中心和传统数据中心最大的区别就是虚拟和真实。

云数据中心的业务是承载在虚拟主机上;而传统数据中心的业务承载在物理主机上。当传统的物理主机已经被虚拟主机替换,传统负载方式就要改变!由于虚拟机存在备份、漂移,那么对虚拟主机的配置、部署、监控就成为了额外的负担。

在云数据中心,负载均衡和虚拟主机之间必须有一些联动的配合,这就要求负载设备也放在一个云上,和虚拟主机联动。这其中包括一些自动移除、自动监控、自动恢复等配置。就算是虚拟主机发生了问题,在云上的负载设置也能不通过人工实现自动重启。

为实现虚拟机联动,太一星晨技术团队经过仔细研究决定采用T-Force V应用交付设备,并制定了针对性的部署方案:

太一星晨T-Force应用交付产品凭借可紧密跟随业务主流的虚拟化技术,能很好的实现与VMware主机联动,并且能专门针对VMware vSphere架构下的应用高可用性和自动化运维提出解决方案。

最终,通过与虚拟主机的联动,T-Force应用交付产品实现了对虚拟主机的自动发现、自动部署以及自动移除功能。极大的减少服务器集群扩容时,运维人员的工作量。

举重若轻 承载大数据量访问游刃有余

作为山西省公安厅警务云的核心设备,其承载的业务访问量与部门信息安全的重要性是毋庸置疑的。面对全省的超大信息量查询访问压力,太一星晨T-Force V应用交付设备则展示展现出了其强大的性能优势。

太一星晨的V系列应用交付设备采用独有的双星型交换架构,配置单板120G的吞吐量,640G大容量交换背板,自然成为了为云平台量身打造的核心利器!

此外,由于“警务云”内业务繁多,不同业务的安全性、隔离也是云计算数据中心的一大挑战。以往,传统负载产品必须通过部署多台单独的硬件设备实现,这会造成极大的资源浪费。如今,太一星晨T-Force应用交付设备具备灵活的硬件虚拟化“一虚多”的能力,则可以很好地满足云平台的业务隔离和弹性调配需求:只要通过在物理主机上部署虚拟主机,就可有效解决传统分布部署带来的缺陷,同时通过虚拟化技术将大容量的硬件资源转换为灵活匹配业务的虚拟服务资源,便可灵活有效的支撑山西省公安厅警务云的应用。

由此可知,基于太一星晨T-Force应用交付设备,多个业务系统只需部署一台独立的物理主机上,不但可以有效解决问题,而且单独的物理主机还极大节约了空间及能源开销,也大幅减轻了维护成本。

因此,T-Force V系列平台,无论是从性能、硬件虚拟化还是安全性角度出发,都是太一星晨专为大型数据中心、云平台打造的独门利器,有了它在“警务云”中的强大支持,警务系统必然将更好地为社会治安保驾护航。

好文章,需要你的鼓励

Instagram长视频内容和个性化订阅可能即将到来

Instagram负责人莫塞里在接受采访时透露,平台正考虑引入长视频内容功能,尽管此前一直专注于短视频。他承认为了吸引优质内容,Instagram可能需要支持长视频格式。此外,Meta最近推出了"您的算法"功能,旨在让用户更好地控制信息流内容。莫塞里承诺未来将提供更多工具,让用户主动塑造个性化内容,但完整实现可能需要2-4年时间。

香港大学联合Adobe研究突破:让AI既能看懂图片又能生成美图的“万能大脑“

香港大学联合Adobe研究院提出PS-VAE技术,成功解决了AI无法同时具备图像理解和生成能力的难题。通过创新的两阶段训练策略,让AI既能准确理解图片语义,又能生成高质量图像,在图像编辑任务上性能提升近4倍,为统一视觉AI系统开辟新路径,在数字创作、教育、电商等领域具有广阔应用前景。

至顶AI实验室硬核评测:戴尔 Precision 5490移动工作站搭建Open Deep Research,打造专属于你的全流程AI研究助手

在信息爆炸的时代,AI实验室的研究员们常常需要面对海量的论文、专利文件、论坛发言等各种渠道的信息。传统的查找方式不仅费时费力,还容易遗漏关键内容。那么,有没有一种方式能让AI真正代替人工,完成从找资料到写出稿的全流程工作?

华中科技大学与马里兰大学联合发现:AI评判员可能比想象中更不靠谱

华中科技大学与马里兰大学研究团队开发出Sage评估框架,首次无需人工标注即可评估AI评判员可靠性。研究发现即使最先进的AI模型在评判任务中也存在严重不一致问题,近四分之一困难情况下无法保持稳定偏好。团队提出明确评判标准和专门微调等改进方法,为构建更可靠AI评估体系提供重要工具。

高性能 AI 边缘推理服务器MIC-743-AT

Instagram长视频内容和个性化订阅可能即将到来

NVIDIA DGX Spark

Dell Pro Max with GB10

至顶AI实验室硬核评测:戴尔 Precision 5490移动工作站搭建Open Deep Research,打造专属于你的全流程AI研究助手

惠普ZBook Fury G1i高性能移动工作站

至顶AI实验室硬核评测:夸克 AI 眼镜全链路"无切换体验",当AI助手真正走进日常

夸克AI眼镜

至顶AI实验室硬核评测:据说这就是AI手机的形态,贴脸开大,豆包手机上手评测

OpenFlex(TM) Data24 NVMe-oF(TM) 存储平台

英特尔(R) 至强(R) 6776P处理器

Solidigm D7-PS1010 E1.S 液冷固态硬盘