赛普拉斯推出业内首款专为IoT设计的微控制器架构PSoC 6

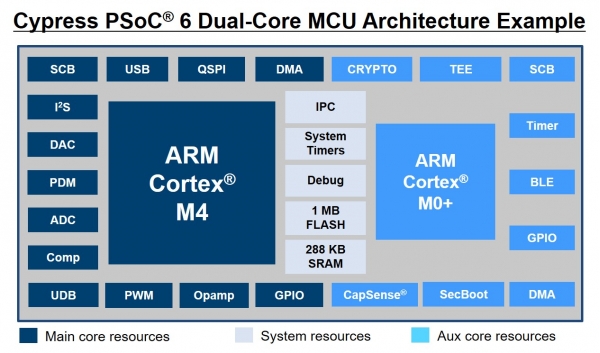

ZD至顶网网络频道 03月30日 综合消息:赛普拉斯半导体公司近日宣布推出专为物联网 (IoT) 设计的最新微型控制器 (MCU) 架构——PSoC 6。该架构基于超低功耗40纳米处理技术,是业内功耗最低、灵活性最高的解决方案,并且集成了下一代物联网设备所需的安全特性。该架构完美的平衡了性能、成本和功耗的需求,填补了相关领域的空白。双核 ARM Cortex-M4与 Cortex-M0+架构使设计者能够同时优化功耗与性能 。通过独特的PSoC结构及简单易用的软件可配置外设,PSoC 6使得工程师们能够设计出创新的下一代物联网设备。

PSoC 6

赛普拉斯总裁兼首席执行官Hassane El-Khoury表示:“作为物联网无线解决方案领域的领导者,我们第一时间认识到,客户需要一个能够在兼顾安全功能的同时更好地平衡性能与功耗的处理器解决方案。我们的PSoC 6微型控制器架构专为解决这些问题而设计,这让我们丰富的物联网嵌入式系统解决方案组合如虎添翼。”

树立业界领先的最新超低功耗标杆

赛普拉斯专有的超低功耗40纳米SONOS处理技术使PSoC 6 微型控制器架构能够在ARM Cortex-M4 和 Cortex-M0+ 内核上分别以22 µA/MHz和15 µA/MHz 工作电流实现业内领先的功耗。凭借动态电压与频率定标 (DVFS) 技术,PSoC 6 微型控制器架构可同时提供保证核心性能与低功耗所需的处理能力。双核架构实现了功耗优化的系统设计,其中的辅助内核可以用作降低主内核功耗,使主内核进入睡眠状态。

可信赖的解决方案助力提高物联网安全性

PSoC 6提供一个基于硬件的可信任执行环境 (TEE),具有安全启动能力与集成安全数据存储的能力,以保护固件、应用程序和安全资产,比如密钥等。PSoC 6 在一个专为分担计算密集型任务而设计的集成硬件协同处理器中执行多种行业标准对称和非对称加密算法,包括椭圆曲线加密(ECC)、高级加密标准(AES)以及安全散列算法(SHA 1、2、3)。该架构无需外部存储器或安全元件就能支持多个同步安全环境,并且为多个独立的用户定义安全策略提供可扩展的安全存储。

赛普拉斯微型控制器业务部门副总裁John Weil表示:“每台联网设备都可能存在潜在的网络隐患。由于存在不计其数的潜在隐患,因此安全性变得至关重要,而且物联网设备最底层的安全设计成为重中之重。我们设计的PSoC 6可以帮助我们的客户保护产品免受网络攻击,同时能够促使他们利用灵活、方便易用的PSoC架构创建前所未有的创新物联网设备。”

通过直观的软件支持实现前所未有的创新型物联网设备

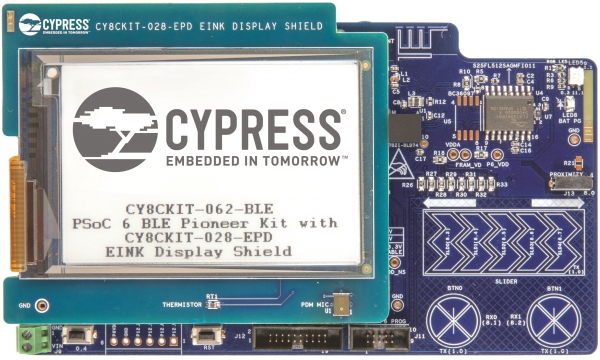

除了顶尖的灵活性与易使用性之外,PSoC 6还能推动创造出差异化的、前瞻性的物联网设备。软件定义的外设可用于创建自定义模拟前端 (AFEs),或如电子墨水显示器等创新系统组件的数字接口。该架构提供灵活的无线连接选项,包括全集成低功耗蓝牙 (BLE) 5.0等。PSoC 6 微型控制器架构采用了赛普拉斯业内领先的最新一代CapSense®电容感应技术,支持强大而稳定的先进触摸和手势界面。赛普拉斯PSoC Creator™ 集成设计环境 (IDE)和各种ARM生态系统均支持该架构。

供货情况

PSoC 6芯片、套件与软件目前已经开始向部分战略合作伙伴提供。更多关于PSoC 6信息,敬请访问www.cypress.com/PSoC6 ,注册参与PSoC 6早期使用者项目(PSoC 6 Early Adopter Program)后可获取更多资料。该产品预计于2017年第四季度初全面投产。

好文章,需要你的鼓励

欧洲银行计划因AI发展裁员20万人

摩根士丹利最新分析显示,到2030年欧洲银行业可能削减超过20万个工作岗位,约占35家主要银行员工总数的10%。裁员主要集中在后台运营、风险管理和合规等领域,银行预期通过AI技术实现30%的效率提升。荷兰银行ABN Amro计划到2028年裁员五分之一,法国兴业银行CEO宣称"没有什么是神圣不可触碰的"。高盛也警告美国员工将实施裁员和招聘冻结。

ETH苏黎世突破性WUSH技术:让AI大模型压缩实现接近零损失的革命性方案

瑞士ETH苏黎世联邦理工学院等机构联合开发的WUSH技术,首次从数学理论层面推导出AI大模型量化压缩的最优解。该技术能根据数据特征自适应调整压缩策略,相比传统方法减少60-70%的压缩损失,实现接近零损失的模型压缩,为大模型在普通设备上的高效部署开辟了新路径。

Safe公司CEO:AI是助手而非替代者

Safe软件CEO唐·默里认为,AI作为助手不可或缺,但绝非权威。他指出,在工程等高精度领域,AI准确率仅达80-90%,远低于99.999%的要求,因此必须保持"人在回路中"模式。默里担心企业过度依赖AI而不培养初级员工,当资深专家退休后将面临人才断层。他强调AI应用于提升团队整体水平,帮助初级员工快速成长,协助资深员工提高效率,但人类专业判断不可替代。

机器人终于能读懂你的手势了!弗吉尼亚大学团队让机器人变身“人类动作翻译官“

弗吉尼亚大学团队创建了Refer360数据集,这是首个大规模记录真实环境中人机多模态交互的数据库,涵盖室内外场景,包含1400万交互样本。同时开发的MuRes智能模块能让机器人像人类一样理解语言、手势和眼神的组合信息,显著提升了现有AI模型的理解准确度,为未来智能机器人的广泛应用奠定了重要基础。

Mac新机必装应用程序完整指南

欧洲银行计划因AI发展裁员20万人

Safe公司CEO:AI是助手而非替代者

印度农业科技公司Arya.ag获8100万美元D轮融资

OpenAI押注音频技术,硅谷掀起无屏设备竞争

CIO如何将AI试点成功扩展至企业级部署

回顾2025,英特尔为AI打下了哪些基础?

从十城抢租到场景落地,擎天租以创新租赁模式推动机器人普惠化

Proteintech选择亚马逊云科技为首选云服务商,构建行业首个AI抗体助手加速科研创新

大模型落地元年:AI Agent如何打破测试“效率墙”,重塑数智化质量基座?

从工具到团队:万智2.5多智能体正在改写企业决策与执行全链路

AI智能体Sweekar:90年代电子宠物的现代继承者