服务主机的路由器与负载均衡和实现思路

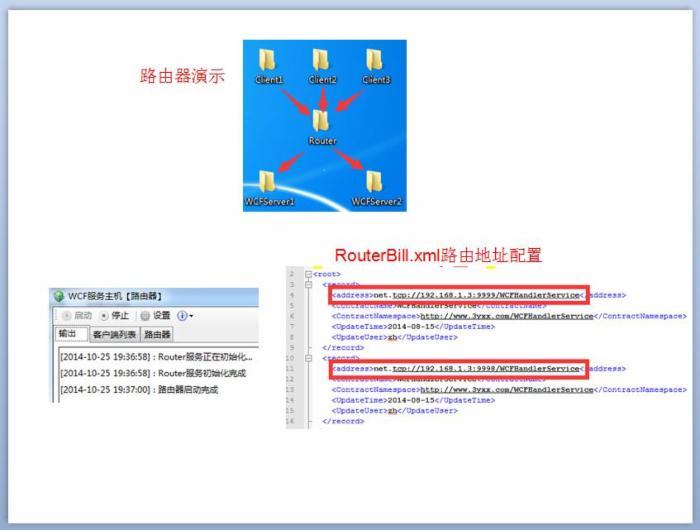

路由器介绍及演示

WCF中间件的路由功能是在客户端与服务端之间加入中介服务,用来转发它们之间的消息。实现消息的转发可以修改WCF服务消息头的内容,重新指定服务地址即可,那给消息头指定的服务地址从哪来,需要给路由器配置服务端地址目录,路由器与服务端肯定不是一对一的,路由器可以指定多个服务端,而路由器把客户端连接指定给哪个服务端这里就有一个算法,算法的优劣就决定了中间件负载均衡的能力。

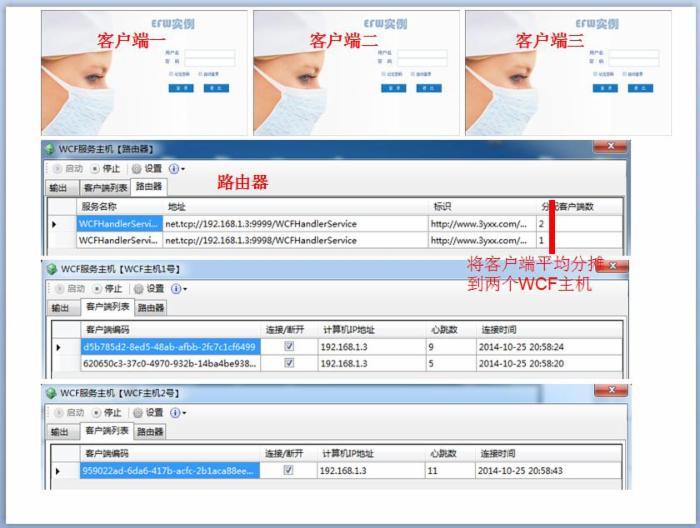

下面演示了中间件的路由功能,把Out目录中的程序复制6份,分别改名如下,3个客户端,1个路有中间件,2个服务中间件,还要修改每个程序的相关配置;这样先启动路由中间件Router和服务中间件WCFservser1、WCFServer2,然后分别启动2个客户端程序,路由中间件和服务中间件就会显示客户端的连接信息。3个客户端会有2个分配到一个服务中间件,一个客户端分配到另外一个服务中间件,不会说3个客户端都分配到1个服务中间件,这是由路由中间件的负载均衡算法决定的;

路由功能的实现

框架增加了一个路由服务对象Router,用它来拦截客户端发送的消息,拦截方法ProcessMessage(Message requestMessage);

首先根据路由目录结合负载均衡的算法取得服务地址endpointAddress,然后创建WCF通道并绑定新的服务地址,调用服务端的方法;

- ///<summary>

- ///截获从Client端发送的消息转发到目标终结点并获得返回值给Client端

- ///</summary>

- ///<paramname="requestMessage"></param>

- ///<returns></returns>

- publicMessageProcessMessage(MessagerequestMessage)

- {

- //Bindingbinding=null;

- EndpointAddressendpointAddress=null;

- GetServiceEndpoint(requestMessage,outendpointAddress);

- IDuplexRouterCallbackcallback=OperationContext.Current.GetCallbackChannel<IDuplexRouterCallback>();

- NetTcpBindingtbinding=newNetTcpBinding("netTcpExpenseService_ForSupplier");

- using(DuplexChannelFactory<IRouterService>factory=newDuplexChannelFactory<IRouterService>(newInstanceContext(null,newDuplexRouterCallback(callback)),tbinding,endpointAddress))

- {

- factory.Endpoint.Behaviors.Add(newMustUnderstandBehavior(false));

- IRouterServiceproxy=factory.CreateChannel();

- using(proxyasIDisposable)

- {

- //请求消息记录

- IClientChannelclientChannel=proxyasIClientChannel;

- //Console.WriteLine(String.Format("Requestreceivedat{0},to{1}\r\n\tAction:{2}",DateTime.Now,clientChannel.RemoteAddress.Uri.AbsoluteUri,requestMessage.Headers.Action));

- if(Convert.ToInt32(HostSettingConfig.GetValue("debug"))==1)

- hostwcfMsg(DateTime.Now,String.Format("路由请求消息发送:{0}",clientChannel.RemoteAddress.Uri.AbsoluteUri));

- //调用绑定的终结点的服务方法

- MessageresponseMessage=proxy.ProcessMessage(requestMessage);

- //应答消息记录

- //Console.WriteLine(String.Format("Replyreceivedat{0}\r\n\tAction:{1}",DateTime.Now,responseMessage.Headers.Action));

- //Console.WriteLine();

- //hostwcfMsg(DateTime.Now,String.Format("应答消息:{0}",responseMessage.Headers.Action));

- returnresponseMessage;

- }

- }

- }

负载均衡的实现

负载均衡实现代码在Router对象中的GetServiceEndpoint方法中,定义了RegistrationList对象用来存储客户端列表,在消息头中增加了两个标识routerID和CMD,routerID用来识别客户端,值是客户端创建发送到路由中间件,每个客户端只有一个routerID;CMD用来客户端发送给路由中间件的命令标识,这里只用到了一个就是”Quit”就是卸载路由中间件中的RegistrationList客户端列表;

解决了识别客户端的问题,那平均算法每个客户端分配到哪个服务中间件就很简单了,RoundRobinCount就记录每个服务中间件对应的客户端个数,哪个服务中间件数量少新的客户端就分配给它;

- privatevoidGetServiceEndpoint(MessagerequestMessage,outEndpointAddressendpointAddress)

- {

- stringns="http://www.3yxx.com/";

- stringrouterID=GetHeaderValue("routerID",ns);

- stringcmd=GetHeaderValue("CMD",ns);

- stringcontractNamespace=requestMessage.Headers.Action.Substring(0,requestMessage.Headers.Action.LastIndexOf("/"));

- RegistrationInforegInfo=null;

- if(Router.RoundRobinCount.ContainsKey(routerID))

- {

- intkey=Router.RoundRobinCount[routerID];

- regInfo=Router.RegistrationList[key];

- if(cmd=="Quit")

- {

- regInfo.ClientNum-=1;

- }

- }

- else

- {

- //根据指定的协议名称空间从注册表容器中得到注册项列表

- varresults=fromiteminRouter.RegistrationList

- whereitem.Value.ContractNamespace.Contains(contractNamespace)

- orderbyitem.Value.ClientNumascending

- selectitem;

- if(results.Count<KeyValuePair<int,RegistrationInfo>>()>0)

- {

- varval=results.First<KeyValuePair<int,RegistrationInfo>>();

- Router.RoundRobinCount.Add(routerID,val.Key);

- val.Value.ClientNum+=1;

- regInfo=val.Value;

- }

- }

- UriaddressUri=newUri(regInfo.Address);

- //binding=CustomBindConfig.GetRouterBinding(addressUri.Scheme);

- endpointAddress=newEndpointAddress(regInfo.Address);

- //重设Message的目标终结点

- requestMessage.Headers.To=newUri(regInfo.Address);

- hostwcfRouter(RegistrationList.Values.ToList());

- }

WCF客户端配置和中间件配置还有路由地址配置

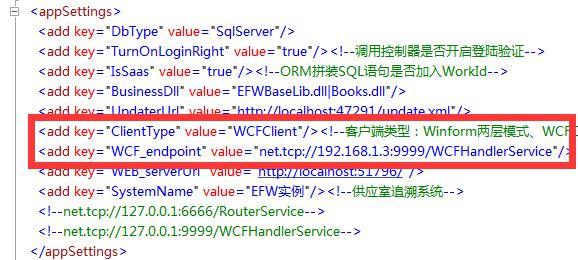

如果部署的时候不使用中间件的路由功能,那客户端配置服务地址直接指定服务端WCF地址就行了,而如果启用路由功能,那客户端就配置路由中间件的WCF地址,路由中间件再配置路由目录,对应服务端;

客户端WCF配置和服务端WCF配置还有一个地方值得注意,就是netTcpBinding节点的配置;最好配置为取消服务器凭据认证,因为如果不配置为None,当客户端断开连接后再连接的时候就会一些安全性验证,导致连接报错,所以对WCF安全性方面的配置没有吃透的话还是先这样配置好;

1)客户端App.Config配置

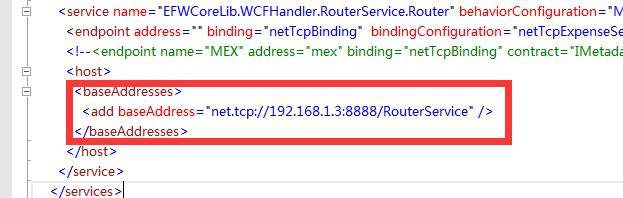

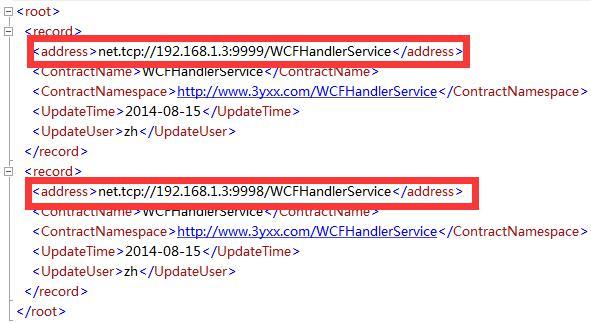

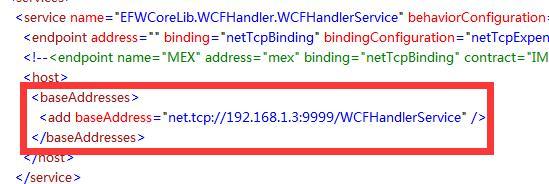

2)路由中间件App.Config配置和路由目录RouterBill.xml配置

3)服务中间件App.Config配置

5.总结

本章我们详细讲解了EFW框架中的WCF中间件的路由功能和负载均衡的实现,代码很简单,但深入理解却没那么容易,我也只是略懂点皮毛,参考了网上资料把功能实现而已,而想要做成专业级别的中间件是有一个过程的,所以不只是我,也需要有兴趣的人一起完善它;

路由实例程序下载 :http://pan.baidu.com/s/1eQ8FscE

注意:实例中的配置文件中的IP地址192.168.1.3修改为你本机的IP地址;(博客园)

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本

Veeam修复CVSS评分9.0的严重远程代码执行漏洞

首届“国家绿色算力设施”推广交流活动开幕在即

阿里云发布多模态交互开发套件,让硬件能听、会看、会交互

至顶AI实验室硬核评测|落定个人AI超算下一块“拼图” NVIDIA DGX Spark实现本地千亿级参数模型推理