重磅!GDN·全球数字风险阻断网络,正式发布!

8月18日,由亚洲领先的DRP数字风险防护领导者企业天际友盟牵头举办的「GDN·全球数字风险阻断网络」发布会于北京正式召开。

什么是GDN

随着数字化进程的加快,企业对于数字风险防护管理的需求与日俱增,其数字足迹、数字资产,甚至高管的个人形象都可能成为不法分子的攻击目标。保护关键数字资产与数据免受外部威胁,提升在线业务运营稳健性的价值毋庸置疑。

天际友盟基于多年数字风险防护实践,依托全球情报分析和处置能力,携手业界数字基础设施管理平台和行业能力合作伙伴,共同打造了全球数字风险阻断网络·GDN(Global Disruption Network)。

GDN的宗旨是—联合生态力量,抵御数字风险,打击网络犯罪。

GDN能做什么

GDN的成立,可以大大提升数字风险防护的生态协同能力,成员机构的协作流程如下:

Step1.确认数字风险:天际友盟通过自主监控和生态情报,整合并评估数字风险。

Step2.分发GDN网络:天际友盟将数字风险传递至GDN网络成员。

Step3.打击数字风险:GDN合作伙伴依照其内部风险评估机制对风险采取阻断行动。

- 合作伙伴依照其内部风险评估机制对处置中的风险中断服务;

- 合作伙伴对确认的数字风险,进行中断和打击操作(例如阻止对恶意内容的访问);

- 天际友盟跟踪整个处置过程,以及阻断的效果。

通过以上工作流程协同合作,GDN成员能够快速阻止用户对恶意站点和内容的访问,主动治理数字风险,阻止潜在威胁。同时,成员可以通过共享风险情报和攻击指标协同阻止恶意内容,有效提高用户数字业务安全体验。

GDN的出现协同联动了多方行业生态力量,成员之间专业能力互补互助,以共同保障用户业务数字化旅程的安全。

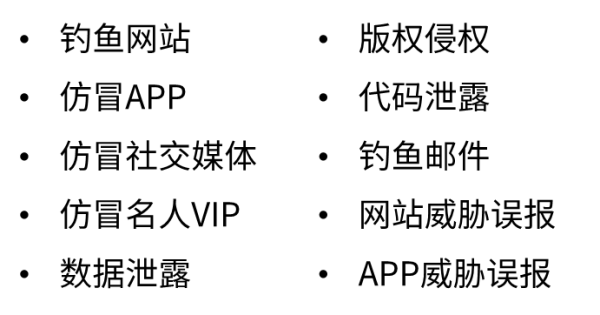

GDN成员的义务

打击数字风险欺诈—GDN合作伙伴应高效积极打击平台涉及的数字风险内容,强化平台自主管理风险的义务,助力构建和谐网络环境。

阻断数字风险路径—GDN合作伙伴对于在多个平台中流转的数字风险和网络犯罪,应在自由平台上完成链路阻断,严防风险的传播及叠加共振。

消除数字风险误报—对于误报类数字风险,平台应给予绿色通道,高效审核并恢复误报信息。

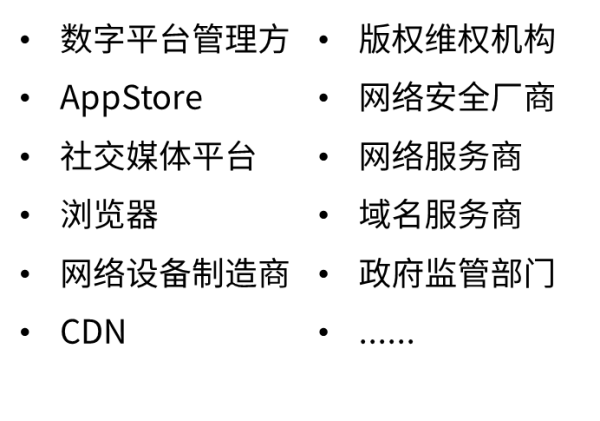

GDN成员机构

(更多机构,持续更新)

加入GDN,企业机构能够更好的承担ESG社会责任,为更好的互联网环境和数字风险治理贡献一份力量,并有机会获取天际友盟提供的专有DRP Feed—数字风险防护明文情报!

Join us now!

来自GDN发布会的声音

GDN发起单位天际友盟创始人兼CEO杨大路表示:“GDN全球数字风险阻断网络是天际友盟基于多年数字风险防护实践,依托全球情报分析和处置能力,携手业界数字基础设施管理平台和行业能力合作伙伴,共同打造的全球数字风险阻断网络。希望GDN的出现能够为各方建立起高效、有效的沟通桥梁,及时以最快的速度将数字风险扼杀在萌芽阶段,更好的保障用户业务数字化旅程的安全。”

GDN成员单位北京反侵权假冒联盟副秘书长侯颖表示:“北京反侵权假冒联盟CAASA在‘共治、共建、共享’的基础上,通过多方联动,为会员单位构建了社会共治立体保护体系。在天际友盟的技术支持下,联盟已经为会员单位处理了多起侵权域名下架案例。得到了会员单位非常高的认可与信任。联盟以保护知识产权,打击侵权假冒为核心,很荣幸与天际友盟共同携手,构建知识产权大保护格局,为数字经济发展保驾护航。”

GDN成员单位北京腾瑞云文化科技有限公司副总赵玺媛表示:“目前数字版权侵权形式多、分布广,并且随着网络技术的进步有了更快的扩散速度,应对这一局面,及时阻断侵权内容的传播尤为重要。CPSP版权平台通过数字身份标识、数字水印追踪、数字资产加密做到侵权的“事前防御”;以区块链存存证取证、全网检测、侵权维权做好侵权的“事后保护”。平台还具备多维维度相结合打击的能力,可及时阻断侵权行为,保护数字版权资产价值。”

来源:业界供稿

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。

联想集团混合式AI实践获权威肯定,CES期间获评“全球科技引领企业”

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

CES 2026 | 重大更新:NVIDIA DGX Spark开启“云边端”模式

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

研究发现商业AI模型可完整还原《哈利·波特》原著内容

Razer在2026年CES展会推出全息AI伴侣项目

CES 2026:英伟达新架构亮相,AMD发布新芯片,Razer推出AI奇异产品

通过舞蹈认识LimX Dynamics的人形机器人Oli

谷歌为Gmail搜索引入AI概览功能并推出实验性AI智能收件箱

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

OpenAI推出ChatGPT Health医疗问答功能

Anthropic寻求3500亿美元估值融资100亿美元