Aryaka干了一件很酷的事:把WAN优化变成了托管式服务 原创

说到广域网(WAN)优化可能对很多人还比较陌生,但要说广域网加速可能就更容易理解,其实广域网(WAN)优化通常就是被称为广域网加速,即通过一些优化技术来提供高性能的远程数据访问,从而提高应用程序在广域网上的性能。而广域网就是相对局域网而言的,可以简单粗暴的理解为Internet。那么,简单来说广域网(WAN)优化就是对网络的加速。

这项技术对我们其实非常重要,无论你是网上购物、下载文件、看视频、玩游戏等等,只要你上网就离不开广域网(WAN)优化,尤其是在今年疫情爆发以来,很多工作和学习都搬到了线上,当你在家开远程会议,或者听大洋彼岸的老师为你上课辅导的时候,更是要得益于这项技术所带来的支撑。只不过其一直都是在背后默默无闻的为你提供着服务,所以我们才感觉不到它的“存在”。

而就在广域网(WAN)优化这个领域中,就有一家非常酷的企业叫做Aryaka,之所以说酷是因为这家企业并不只是提供传统的广域网(WAN)优化技术产品和解决方案,而是能够提供一种广域网(WAN)优化的托管服务。这对很多企业用户来说,简直是一个福音。

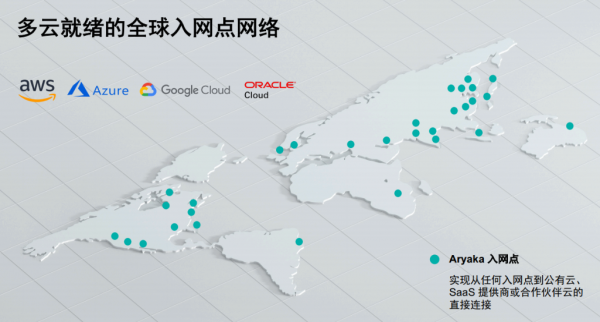

Aryaka产品及解决方案营销副总裁David Ginsburg表示,“Aryaka的产品与服务主要是针对WAN优化,包括点对点的全面连接服务,同时也专注于连接所有的云厂商,可以称之为Cloud First'云优先'的WAN优化,而Aryaka把自己定位为一家托管型的WAN优化厂商,可以帮助客户解决在全球范围实现企业组网的一种场景,这也是与其他厂商不同的地方。”

这种托管式服务,可以对包括软件层面、硬件层面、网络层面实现全部覆盖,用户只需要将自己的网站连接到Aryaka的网络上即可,而Aryaka负责从底层到上层,硬件到软件的全部打包化服务,用户只需连接即可享受WAN优化的全部功能,更不需要自己购买诸如SD-WAN等相关设备,这一切繁琐的工作都由Aryaka以一种集成式的服务呈现在了用户面前。这听上去确实很酷。

而这种类似于SaaS服务的托管方式与传统广域网(WAN)优化方式有何区别呢?Aryaka产品管理副总裁Hugo Vliegen表示,“今天的客户大都需要快速解决网络问题,传统的方式平均需要几个月的时间才能最终实现效果,更不会提供端到端的可视化能力。 而Aryaka整合全球所有资源去帮助客户实现托管式的优化服务,可以在最短时间解决问题,这在今天远程办公的趋势下显得尤为重要。”

另外,这种托管式的服务最直接的减轻了企业用户的运维压力,尤其更加弥补了众多中小型企业中技术人才短缺的问题,用户完全不用担心技术的复杂性,更不用操心后续维护的问题。

而更直接的优势还在于用户不用购买相关设备,相应的设备和维护人员费用全部节省掉了,这点对很多轻资产的企业来说至关重要,这些成本的节约让这种托管式的服务方式能够更加灵活的适应企业未来业务的发展需求。

基于以上这些优势,Aryaka所提供的这种托管式WAN优化服务很可能将成为今后广域网(WAN)优化市场中的主流趋势,通过更加轻量化的投入即可享受到快速灵活的WAN优化功能,这在某种程度上或许将取代很大一部分传统运营商和专线式的WAN优化市场份额。

而Aryaka确实做了一件很酷的事情,就是通过“云优先”方案,打破了传统的交付方式,提供给用户一种能够快速上线、简化运营,并多云就绪的广域网(WAN)优化的使用选择。

值得一提的是,得益于客户至上的企业文化,以及始终坚持“不断超越服务标准”的服务团队,Aryaka已经凭借高度细分的托管SD-WAN产品在托管服务提供商行业中获得了超过65的最高净推荐分数 (NPS),这不得不说真的“很酷”!

好文章,需要你的鼓励

7个家庭AI技巧让智能聊天机器人相形见绌

家庭智能设备中的AI技术正在发挥惊人作用,包括摄像头的深度物体和活动识别、升级版语音助手如Alexa Plus/Gemini,以及能够节省开支的机器学习功能。这些应用涵盖包裹识别、声音监测、智能恒温器学习日常习惯、宠物行为识别、对话式语音控制、用水监测和漏水检测,以及视频事件摘要等七大功能,为用户提供更智能便捷的家居体验。

ByteDance联手顶尖学府重新定义AI思考:当机器学会分层理解世界

ByteDance等机构联合提出DLCM模型,通过学习语义边界动态分配计算资源,将AI从统一令牌处理转向层次化概念推理。该模型引入压缩感知缩放定律,在12项零样本测试中平均提升2.69%准确率,为构建更智能高效的AI系统开辟新路径。

Mac成为企业环境中最可持续设备的原因调查显示

MacPaw最新调查显示,自M1芯片发布五年来,Mac设备在企业中的使用寿命显著延长。近半数受访企业的Mac使用3-5年仍保持良好性能,这得益于M系列芯片出色的稳定性和能效表现。IT团队正转向自动化管理工具和AI辅助workflow来应对人手不足的挑战。虽然设备更耐用减少了硬件更换频率,但IT部门面临的安全威胁和管理复杂性持续增加,需要更简化的软件更新流程。

香港中文大学团队突破:让AI有了“超级记忆“,多步推理能力飙升!

香港中文大学团队突破AI记忆瓶颈,提出HGMEM超图记忆机制。该技术让AI具备类似人类的联想思维,能将分散信息整合成高阶理解。通过动态记忆演化和智能检索,显著提升了复杂推理能力,在长文本理解任务中全面超越现有方法,为AI向"知识理解者"转变开辟新路径。

Instagram负责人:你的眼睛已经不能分辨什么是真实的了

派拓网络安全官:智能体将成2026年最大内部威胁

Subtle发布搭载降噪模型的无线耳机

Xreal发布新款AR眼镜和电源集线器,革新工作娱乐体验

纳瓦尔Flow 2扫地机器人问世:配备AI识别技术能找到丢失物品

7个家庭AI技巧让智能聊天机器人相形见绌

Mac成为企业环境中最可持续设备的原因调查显示

首次独居必备的10款实用智能设备推荐

OpenAI重组团队开发语音AI硬件产品,2026年推出新模型

AI重塑工作格局:Mercor如何连接人才与智能体训练

科技巨头在股价飙升中套现160亿美元

联想问天 WR5215 G5服务器重磅发布:以能效和性能树立单路服务器新标准

Gartner 魔力象限:Palo Alto Networks及新增的 Cato 和 Netskope 成为单一供应商 SASE “领导者”

Check Point+七云网络 强强共建SD-WAN安全

因聚而生,共建生态 | 华为园区SD-WAN与光环新网携手合作,共筑数智变革高效蓬勃发展

Fortinet谢青:有信心在未来几年跻身SD-WAN市场份额首位

安全、智能、高效 Fortinet蝉联SD-WAN领导者

拒绝互联网玩法,启动之初就盈利,凌锐蓝信创始人顾玮的创业法则

唯一!Fortinet连续两年跻身Gartner SD-WAN最佳执行力榜首

思科和Megaport携手合作简化SD-WAN

一网接入 全球互联——Aryaka 托管 SD-WAN 技术访谈

中国电信国际有限公司与Aruba助力企业扬帆出海的战略协议是如何达成的