智能运维 让企业无线达到极致 原创

极致,是一种追求,更是一种态度。而企业对产品的极致追求,更是企业负责任的一种体现。下面就让我们来看一下,新华三企业无线是如何在标准相同、指标相近、功能相仿的同质化时期,利用智能运维,将无线产品做到极致的。

网络智愈,让客户回归业务本身

在与新华三集团无线产品线总经理赵玉金的沟通中我们可以了解到,新华三在2017年8月8日首发了Wi-Fi 6企业无线之后,几乎实现了Wi-Fi 5到Wi-Fi 6的产品切换。随着客户逐渐回归于业务本身,怎么让客户业务好用、易用、体验好,以及让他们省更多的人力去思考真正的业务,成为新华三一直在思考的地方。

新华三集团无线产品线总经理赵玉金

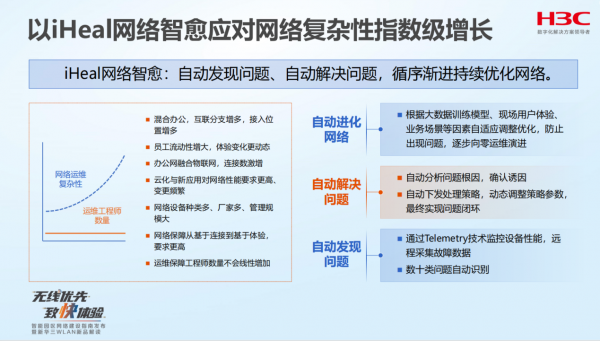

在随后的大约五年多时间里,新华三通过大数据和AI的方式,解决运维的问题,实现网络问题自动优化,达到“网络智愈”。 “网络智愈”最终的目的是免运维,让运维这个服务成为一种远程监控和提醒,最后全部交给新华三的智能运维自己去渐进优化,达到一个理想状态。

例如,在赵玉金的实例讲解中我们可以了解,在新华三协助建设的某校园无线网络中,师生经常遇到走出校门口后,即使有无线信号,但是扫不了共享单车的问题。这是因为校门口属于学校边缘,无线信号不好,因此影响到应用的正常使用。新华三了解到这个问题,在与师生进行深入探讨后,给出了其基于智能运维的独到解决方案。即依据边缘AP和它的漫游轨迹进行路线分析,当分析出这个终端是要离开校园后,一旦终端离开AP的有效范图,就自动让它离开网络。至此校门口因连接无线无法扫描共享单车的问题也就解决了。

此外,还有很多无线运维问题,同样可以依据智能运维去进行解决。比如在一些高密度无线接入场景中,常常遇到的“乒乓漫游”问题。当终端处于两个AP信号相仿的AP之间,很容易出现反复切换的情况,当达到一定频次时,智能运维就可以判定它是“乒乓漫游”。这时候的解决方案就是将其中的一个AP信号稍微增强一点,基本就可以解决这方面的问题。

智能运维4i技术,让无线接入更快速、更智能

智能运维看上去很简单,但实际上想要真正成功运营,需要有一套体系化的技术积累进行支持。新华三将其总结为iRadio、iStation、iHeal和iEdge。

首先,iRadio是解决空口的问题。比如ARP报文,因为它是广播报文,用最低的速率发送,直接就把空口资源占满了。所以,我们一定要站在业务本身来考虑,要把空口资源省出来让真正的业务使用,省出1%,这个网络就好用了。

其次,iStation是解决终端更快更好地接入问题。以前经常会提2.4G和5G的接入导航,如果发现终端支持5G,但想接2.4G,就尽量不让它接。现在的终端如果是双频的,都会优先接5G的。

以上两点是基础,而核心则是新华三的iHeal,通过把服务和研发人员碰到的实际问题的数据可视化,利用数据发现和分析,去解决实际的问题,最大化省去现场结局问题的人力和时间成本。目前新华三已经积累了上百种问题解决方案,像“出门问题”、“乒乓问题”等,只要看整个网络终端波动情况,如果发现有信号来回跳的现象,就直接依据相关策略调整AP功率,一点点地把它优化掉。未来,随着时间的积累,新华三收集到的问题和解决方案也会越丰富,智能运维就会越发成熟,从而可以更好的对企业无线网络实施智能化的管理。

当然,智能运维仅仅是新华三企业无线解决方案其中的一部分,还有可以识别关键业务、加速关键业务、重点保障关键业务的边缘感知iEdge;更快速度、更高性能的“智快”无线接入产品。

正是由于这些智能化的运维策略与智能化的高性能无线产品相结合,才可以让新华三的企业无线在追求极致的道路上越走越远,从而让企业无线达到极致。

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

OpenAI与软银联手投资10亿美元,助力星门项目能源伙伴发展

Uber联合Lucid和Nuro发布全新自动驾驶出租车

始于Token,不止于Token

埃森哲投资Profitmind,押注AI智能体变革零售业

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

2026年科技行业多元化发展前景与挑战预测

智能体AI推动云安全策略根本性变革

Salesforce推出AI能力框架助力企业数字化转型

大众汽车牵手高通打造智能网联座舱体验

Ruby 4.0.0发布:引入ZJIT编译器和Ruby Box隔离技术

Meta签约三家核能公司为AI数据中心提供6.6吉瓦电力

大多数开发者不信任AI生成代码却不检查