迎接Edge 2.0,创新数字经济

本文源自F5公司CTO林耕于近日在清华大学的一场圆桌会议上的发言,阐述其对于数字经济发展和Edge 2.0时代的看法。

2020年开始席卷全球的 “新冠” 疫情给全世界带来了更大的变数,但危与机的博弈中,世界的变化并非毫无章法。我们发现,疫情加速了全球数字化的进程,微软CEO Satya Nadella就曾经说过: “在过去几个月内,我们见证了多年才能实现的数字转型进展。”

今天,全球都在走向数字化。根据全球移动通信系统协会(GSMA)统计数据显示,2025年全球联网设备的数量将达到约246亿个。据IDC和Gartner,全球数据量大约每两年就将翻一倍,到2025年,这个数字将疯狂攀升至175ZB,届时大约有超过75%的数据将在边缘侧处理。

可见,万物互联的时代真的来了,它催生了边缘计算的崛起和迭代,并将在未来快马加鞭融入企业乃至社会生活的方方面面。

互联网的第三次浪潮——万物互联的Edge2.0时代

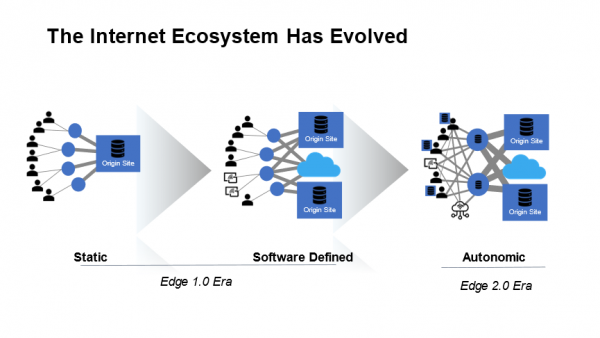

在我看来,边缘计算的崛起和演变将成为互联网第三次浪潮的标志性事件。众所周知,信息技术的变革推动人类走过了PC与互联网时代,以及移动互联网时代,如今向着移动物联网时代迈进。这种进化突出地表现为网络生态系统结构的变化,从静态且封闭的Edge1.0,走向开放和自动化的Edge 2.0,整个过程犹如从单细胞生物到复杂生命体的进化之旅。

更为重要的是,边缘计算正在成为促进行业数字化转型的重要抓手。根据F5刚刚发布的《2021年应用策略现状》报告,76%的企业已经实施或正在积极规划边缘部署,而增强应用性能和收集数据/执行分析是主要推动力量。

新一轮的数字化转型中融入了海量的“物” 元素。过往,由于IT(信息技术)与OT(运营技术)彼此分离,尽管云计算带来了算力的极大提升,但物的加入仍然给云模式下的网络架构带来挑战。而在 Edge2.0时代的移动物联网环境中,IT与OT将真正融合起来,并具备更强大的智能感知和自动化能力。换言之,在由云计算的集中式数据处理模式之外,网络边缘将汇集海量设备与数据,并提供靠近终端的强大算力,由此激发巨大的商业价值。

另一方面,边缘网络上的设备与数据增速将远超过核心基础架构能力的增长速度,由此在端到端的应用交付链条中容易形成阻塞点,且边缘计算对于时效性更敏感,延迟将给系统稳定和应用体验带来近乎致命的打击,安全性的挑战也将显著增加。

创新应用交付,从容驾驭互联网新浪潮

对于多数企业而言,实现云端、边缘到终端的一体化应用部署,形成一套有别于当前核心架构的应用交付模式,将是一条通往Edge2.0时代的有效路径。当前,应用和服务交付基本围绕集中模式而构建,并在公有云或私有数据中心内托管。而在Edge 2.0时代,基础架构、数据架构和应用架构都将向更加分散的点对点方向发展。

基于对多云应用安全和应用交付服务技术的多年深耕,F5 始终服务于数字时代中的“应用”这一组织的核心资产。边缘2.0时代的网络由封闭转向开放,F5所提供的解决方案,通过统一的代码,让每个应用安全或交付服务运行在任何服务器和任何云环境中,并实现从云、边缘到应用的覆盖端到端的安全防护,为客户带来 “感知可控,随需而变” 的应用体验。

如今,各行各业都在数字化转型的大路上加速奔跑。我们相信,边缘部署将逐渐成为客户应用策略的一部分,我们也期待与客户携手,在这场互联网的新浪潮中继续“乘风破浪”。

Source:

- 安防知识网:2025年全球物联网总连接数规模将达到246亿https://www.asmag.com.cn/news/202004/103199.html

- 物联传媒-维科网:对比云计算的发展,边缘计算的机会正在孕育https://iot.ofweek.com/2021-01/ART-132214-8500-30482104.html

- https://www.microsoft.com/en-us/microsoft-365/blog/2020/04/30/2-years-digital-transformation-2-months/

好文章,需要你的鼓励

超越能源使用:数据中心可持续运营策略

随着AI广泛应用推动数据中心建设热潮,运营商面临可持续发展挑战。2024年底美国已建成或批准1240个数据中心,能耗激增引发争议。除能源问题外,服务器和GPU更新换代产生的电子废物同样严重。通过采用模块化可修复系统、AI驱动资产跟踪、标准化数据清理技术以及与认证ITAD合作伙伴合作,数据中心可实现循环经济模式,在确保数据安全的同时减少环境影响。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

超大规模云数据中心是数字经济的支柱,2026年将继续保持核心地位。AWS、微软、谷歌、Meta、甲骨文和阿里巴巴等主要运营商正积极扩张以满足AI和云服务需求激增,预计2026年资本支出将超过6000亿美元。然而增长受到电力供应、设备交付和当地阻力制约。截至2025年末,全球运营中的超大规模数据中心达1297个,总容量预计在12个季度内翻倍。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

埃森哲收购英国AI公司Faculty 强化决策智能服务

亚马逊CES发布全新Fire TV界面与Artline彩色边框电视

联想推出跨设备AI智能体,挑战微软和谷歌

麦肯锡和General Catalyst高管:AI时代终结"一次学习,终身受用"模式

联想以AI和数字孪生技术助力2026世界杯

针对D-Link路由器严重远程代码执行漏洞的持续攻击活动

联想Qira AI助手跨设备工作,摩托罗拉AI别针展新机

Deno 2.6新增dx工具运行NPM和JSR二进制文件

西门子CES 2026发布多项技术,加速工业AI革命

Littelfuse推出适用于电动汽车电池、电机和安全系统的汽车级电流传感器

CES 2026 | 机器人开发的“ChatGPT时刻”已到 老黄定调“物理AI”的路线图

超越能源使用:数据中心可持续运营策略