提升服务品质 飞鱼星助力合肥缪酒吧网络升级

合肥缪酒吧.MIU CLUB位于合肥市包河区九华山路与宁国路交口西150米缤购广场,超大空间设计,空中卡座凸显简约与品质、包厢个性与自由、张扬与艺术的空间情绪化表达特点,蜚声国际声光电系统集成,只为你释放较纯粹的自我,常有全球百大DJ驻场,致力于成为合肥顶级至尊夜店。

酒店内部环境

客户需求

当初酒吧在组建Wi-Fi的时候,并没有进行有效的网络规划和现场工勘,直接采用了某知名品牌的无线方案,随着酒吧人气越来越旺,使用Wi-Fi的顾客增多,常出现上网慢或者连上不能用的尴尬局面,已经无法为顾客提供优质的网络服务,同时网络的不稳定也给酒吧的营销人员带来一定的影响,因此将对酒店的无线进行改善,提出了以下几点需求:

1、 能承担600个无线终端同时接入,并且能稳定、流畅的上网;

2、 能实现Wi-Fi的无缝漫游,营销人员来回走动时,手中的工作终端能快速选择最优的网络,无需手动重连。

解决方案

为解决酒吧网络中存的问题,飞鱼星售前工程师在前期做网络规划和工勘前发现,MIU CLUB是一个30米长,23米宽,9米高的一个半二层环境,之前的组网设备存在Wi-Fi无线漫游,无法实现5G优先接入,同时AP安装密集,干扰大,性能也无法承载现有的客户接入需求。

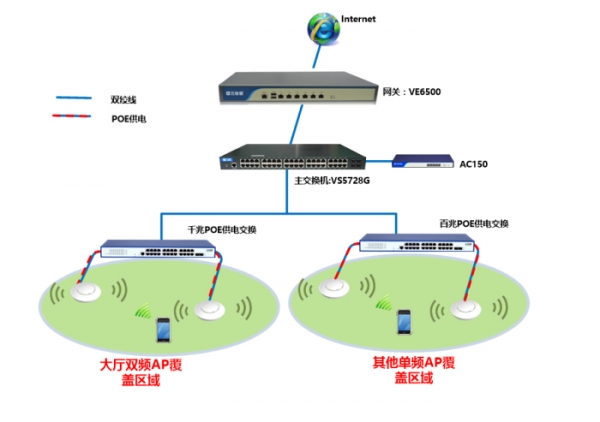

因此,结合酒吧的需求,飞鱼星售前工程师根据酒吧的环境,给出一套场景化无线网络解决方案,该方案由一台VE6500、一台VS5728G、一台AC150、三台VS2026FP、十二台AP313-CH、十台AP303-CH组建而成,有效的解决了酒吧前期网络存在的问题,也满足酒吧的两项核心需求。

酒吧无线网络拓扑图

方案优势

方案中,飞鱼星旗舰级路由器VE6500是作为主网关,设备采用64位双核1.8GHz全千兆网络处理器和2GDDRIII高速内存,双向转发率高达2Gbps,其稳定性和超强的处理能力最高可支持内网1000台终端同时接入使用,同时采用VS5728G万兆交换机作为核心汇聚,提供598G背板带宽交换容量,划分VLAN分配DHCP,保证大流量的数据交换和VLAN广播的隔离,满足内网数据高速转发需求。

在无线覆盖和接入方面,针对人流量较大的一楼大厅,采用AP313-CH双频AP,双频并发下,单台设备最高可支持120个无线终端接入,满足高密度Wi-Fi接入需求,同时1300M的无线传输速率,对于大流量的数据处理更加流畅。而在非大厅区域,采用AP303-CH大功率单频AP,单台设备最高可支持40台无线终端接入,可满足正常上网需求,所有的AP通过PoE交换机进行供电,并提供稳定的数据传输,方案中的两款AP均采用高通芯片,抗干扰能力强,确保顾客能稳定的使用无线网络。

而在AP管理上,采用一台AC150进行旁路部署,实现对网络中所有AP的统一管理对大厅区域和非大厅区域的双频单频AP管理,2.4G和5G设置同一个SSID做到 5G优先连接的方式。针对接入AP人数的限制做到无线STA均衡效果,做到快速的漫游效果,并通过VLAN网段掩码增加,扩大地址段,三层交换的大背板带宽可以有效处理大流量冲击。

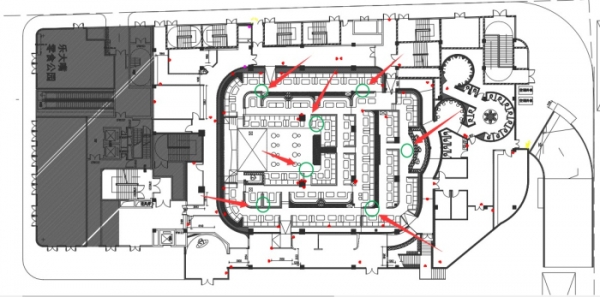

部署在一楼的AP点位说明图

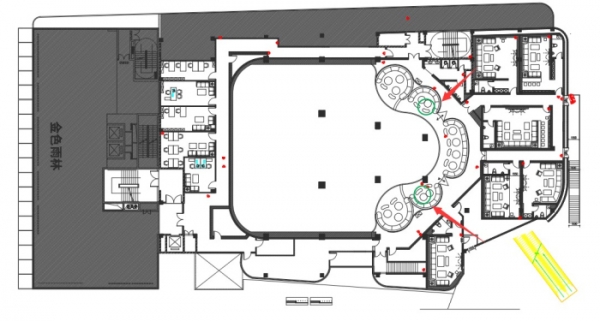

部署在二楼的AP点位说明图

实施效果

这套酒吧场景化无线覆盖解决方案在预算有限的情况下,满足了无线全覆盖、高带机量、安全稳定可靠等需求,现能满足每晚500+终端接入的情况下稳定、流畅上网,没有人抱怨网络不好用,酒吧工作人员在为客人提供服务和顾客付账的时候,再也不会担心因网络问题带来的一些尴尬局面,提供优质的无线服务后,使得顾客在酒吧放松休闲时,都会在微信、抖音等平台中分享,对酒吧进行了更深层次的推广和传播。

好文章,需要你的鼓励

DuRoBo Krono:搭载AI助手的智能手机尺寸电子阅读器

荷兰公司DuRoBo在CES 2026展示新款电子阅读器Krono,采用智能手机外观设计并内置AI助手。该设备定位为"电子纸专注中心",支持阅读、思考和音乐播放。配备智能转盘便于操作,AI助手Libby可回答问题并支持深度思考。搭载Android 15系统,可访问谷歌应用商店。售价239.99欧元,本月发货。

AWS推出AI图像编辑新突破:用说话就能精准移动图片中的物体!

这项由香港中文大学和AWS团队联合开发的研究推出了TALK2MOVE系统,实现了用自然语言精准操作图片中物体的位置、角度和大小。该系统采用强化学习训练方式,通过空间感知奖励机制和智能步骤采样技术,在移动、旋转、缩放三类操作上的准确率显著超越现有方法,同时大幅降低了对昂贵训练数据的依赖,为AI图像编辑领域带来重要突破。

OpenAI推出ChatGPT Health医疗问答功能

OpenAI预览了即将推出的ChatGPT Health功能,可帮助用户获取医疗信息。该功能能解释化验结果、制定运动计划、推荐就医问题等。用户可通过B.well平台导入健康记录,与Apple Health等健康应用集成。OpenAI将单独存储医疗数据,采用专用加密和隔离机制保护隐私。功能基于HealthBench数据集开发,包含超过48000个医生编写的评估标准。目前通过等待名单限量测试。

斯坦福大学等联合发布:AI助手在企业政策执行上竟然“偏科“得如此严重

斯坦福大学等知名机构联合研究发现,企业AI助手在执行组织政策时存在严重"偏科"问题:处理允许请求时成功率超95%,但拒绝违规请求时仅13-40%。研究团队开发的COMPASS评估框架通过8个行业5920个测试问题,揭示了AI助手普遍缺乏"拒绝技能"的问题,并提出了针对性训练解决方案。

OpenAI推出ChatGPT Health医疗问答功能

OpenAI收购高管教练AI工具Convogo团队

抛弃传统的市场推广手册,迎接AI时代的新策略

谷歌将Gemini AI功能推送至Gmail,用户可选择关闭

AI竞赛点燃欧洲数据中心债券市场热潮

IBM API Connect关键漏洞可导致身份验证绕过

CES 2026智能戒指新品:Pebble Index 01记录想法不追踪健康

AI聊天机器人让人上瘾的隐秘手段揭秘

AI将在2026年重塑网络安全策略

CES主题演讲分析:智能体AI如何为现实世界影响奠定基础

Snowflake收购Observe以增强其可观测性能力

三星Galaxy Tab A9 Plus限时降价70美元