“Do More 越创不凡”华为生态伙伴精英赛2018圆满结束

9月16日,以“Do More 越创不凡”为主题的华为生态伙伴精英赛2018颁奖盛典在北京举行。华为企业业务中国区管理团队、合作伙伴高层以及参赛选手共计500余人济济一堂。本届精英赛由华为生态大学主办,设置包括售前、销售、服务、商务、华为云5个领域的10个赛项。最终,82名伙伴获得个人奖项, 43家伙伴获得公司赛奖项。此外,在颁奖典礼上对两位为繁荣ICT人才生态做出杰出贡献的嘉宾授予 “ICT人才生态行动大使”称号。

华为生态伙伴精英赛始于2013年,迄今已是第六届。本届精英赛报名参赛人数突破5000人,再创新高。参赛伙伴不仅来自于华为的合作伙伴,还包括了在校学生和其他生态方的ICT从业者。本届精英赛的成功举办,体现了华为致力于汇聚生态各方人才,将精英赛打造成为中国ICT产业“罗马广场”的决心和信心。

华为EBG中国区总裁蔡英华在致辞中表示:人才战略是中国区ICT市场的首要战略,依托华为生态大学,华为将在校教育、就业、进阶精准赋能的各个环节打通,形成覆盖生态伙伴的人才供应链。从接地气的“大比武”,面对传统渠道伙伴,到精英赛的客户、学生、伙伴的混编参赛,从单纯PK到创造创新,一步一步,都在面向业态的变化和市场的需求,逐步升级和演进。精英赛是个平台,更是中国ICT产业的“罗马广场”,愿更多的伙伴加入其中。

生态各方共同行动,创造生态指数级繁荣——ICT人才生态行动大使授予仪式

在颁奖典礼现场,特别授予中国东方航空云南有限公司信息管理部科长顾福荣、淮安信息职业技术学院UNC通信学院院长孙秀英教授“ICT人才生态行动大使”称号。华为EBG中国区副总裁、华为生态大学校长杨文池及华为EBG中国区副总裁、 企业交付与服务部部长李同广分别为两位“行动大使”颁发了奖杯和证书。同时,杨文池还为孙秀英教授现场颁发了HCIE证书。

杨文池表示:两位“行动大使”都在平凡的工作中不甘平凡,都在不断超越自己,激励着身边人,以实际行动进行ICT人才生态的建设。人才生态建设离不开伙伴、客户、教育界等各方的力量。华为愿与业界各方一起,借助华为生态大学的平台,整合优质资源,构建产业链的数字化转型共同体,打造一个ICT人才产业供给链条。

华为EBG中国区副总裁、华为生态大学校长杨文池

华为EBG中国区副总裁、华为生态大学校长杨文池

为顾福荣父女授予“ICT人才生态行动大使”

华为EBG中国区副总裁李同广

华为EBG中国区副总裁李同广

为孙秀英授予“ICT人才生态行动大使”,杨文池为孙秀英颁发HCIE证书

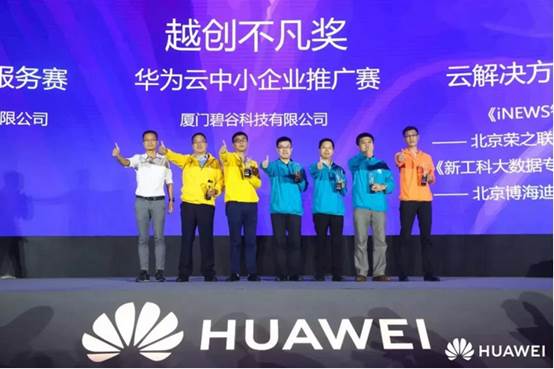

颁奖典礼:精英荟聚,越创不凡

本届精英赛强化了参赛者在典型业务场景下实操与模拟能力的比赛内容。伙伴个人赛增加了华为云精英赛和地市销售精英赛两个赛项,来自4家伙伴公司的5名选手以及来自15家公司的20名选手分别获得两个新增个人赛项的奖项。伙伴公司赛新增华为云中小企业推广赛和解决方案综合服务赛两大赛项,共14家伙伴公司在两个新增公司赛项中获奖。

同时,本届大赛对“联合解决方案”赛制进行了微创新:首次采用伙伴模拟讲标“华为+伙伴”联合解决方案的竞赛形式,推进“华为+A伙伴方案由B销售”的新商业模式。通过大赛,让“A”类伙伴和“B”类伙伴加强方案互通与业务对接,促进伙伴间的多元化合作与生态间的融合。在该项比赛中,共有6家伙伴公司摘得奖项。

聚人才,促融合,赋生态,创价值。华为生态大学通过专业化、体系化的课程,帮助伙伴在学习和实践中成长;更通过一年一度的精英赛,促进交流,实现合作共赢。这是一场知识和技能的竞赛,也是一场高手之间的较量,更是一场精彩的生态盛宴。期待明年再聚首,也期待有更多的伙伴、客户和优秀学生能加入进来。构建开放、共享、共赢的ICT人才生态体系,我们始终在行动!

华为HCIE微电影《礼物》,点击查看:https://v.qq.com/x/page/a0705kd2604.html

好文章,需要你的鼓励

微软CEO纳德拉成AI推广者,呼吁超越低质内容

微软CEO萨提亚·纳德拉希望推动AI接受度进入新阶段,重点关注AI工具如何赋能人类。在微软Copilot订阅和云AI服务收入能否抵消数据中心投资存疑的背景下,纳德拉有动机说服客户和投资者相信AI是明智的长期投资。他在新博客中提出2026年AI发展的三个关键点:将AI视为增强人类能力的工具、从单一模型转向多模型系统协作、以及在AI部署上做出明智的资源配置决策。

ETH苏黎世突破性WUSH技术:让AI大模型压缩实现接近零损失的革命性方案

瑞士ETH苏黎世联邦理工学院等机构联合开发的WUSH技术,首次从数学理论层面推导出AI大模型量化压缩的最优解。该技术能根据数据特征自适应调整压缩策略,相比传统方法减少60-70%的压缩损失,实现接近零损失的模型压缩,为大模型在普通设备上的高效部署开辟了新路径。

法律界巨头LexisNexis推动生成式AI进入法庭实践

法律行业正迅速采用生成式AI技术,用于案件研究、起草和审查等工作。调查显示,80%的法律专业人士认为AI将在五年内对其工作产生重大影响,约四分之三的律所已在使用AI进行文档审查和法律研究。律信数据公司推出的Lexis+ AI平台,整合了超过1380亿份文档记录和AI助手,帮助律师回答复杂问题、生成草案并提供诉讼洞察,成为该公司历史上增长最快的产品。

机器人终于能读懂你的手势了!弗吉尼亚大学团队让机器人变身“人类动作翻译官“

弗吉尼亚大学团队创建了Refer360数据集,这是首个大规模记录真实环境中人机多模态交互的数据库,涵盖室内外场景,包含1400万交互样本。同时开发的MuRes智能模块能让机器人像人类一样理解语言、手势和眼神的组合信息,显著提升了现有AI模型的理解准确度,为未来智能机器人的广泛应用奠定了重要基础。