不只是AI,企业更需要本地HPC

根据Kleyn在采访中的介绍,C500能够支持HPC与AI计算集群,但主要“面向经典HPC环境及运行建模/仿真(例如在HPE构建的计算集群上进行计算机辅助工程的计算流体动力学)的部门。”

HPE推出面向HPC及AI用例的经济高效型存储系统

ClusterStor系列属于HPE在2019年收购Cray时获得的资产,采用SSD加HDD以及Lustre文件系统软件的并行架构。

能源巨头埃尼集团成功将HPC性能提升一个数量级

本周,埃尼集团再次果断出手,委托HPE和AMD为其位于米兰西南部费雷拉·埃尔博尼镇的绿色数据中心构建HPC6系统。

将AI与HPC相结合,寻找更好的电池材料

AMD公司CEO苏姿丰在去年的ISSC主题演讲中表示,这种混合精度方法能够大幅降低电力需求,以有意义的方式扩展计算规模,将相当一部分负载从超级计算集群当中解放出来。

HPC先驱铺平道路,ARM超算有望遍地开花

过去几年以来,Arm架构保持着稳步发展,逐渐在超大规模基础设施运营商和云服务商中开拓出一片天地。但在HPC社区中,Arm的代表性却仍然有限。好在最新消息似乎预计将变革即将到来。

对HPC与AI性能极限的突破,正给可持续发展带来新的挑战

随着摩尔定律逐步放缓,打造更加强大的HPC及AI集群的唯一方式,似乎就只剩下构建更大、更耗电的基础设施。

全球超算500强:谁能从理论峰值中发掘出更多真实性能?

以往,人们大多会关注榜单上的前十名机器,然后再深入研究Top500中的统计学概率。但这一次,本文将收集榜单上前30名机器相关数据及性能指标,希望借此总结当前HPC超算领域第一梯队选手们的共性。

量子计算的基本盘到底有多大……或者说,具体有多小?

作为一家愚见,我们坚定认为量子计算必然会以某种方式融入工作流程,帮助人类解决世界上各种最为棘手的计算问题。

STAMPEDE3:拥有更强处理能力的小型HPC系统

全球所有主要高性能计算中心,无论是直接由科研经费资助、还是靠军方补贴,都凭借明确的需求和充裕的资金在两类超级计算机系统中选择其一。要么拥有极高性能扩展上限,要么能够承载起成百上千只需运行小规模作业的用户。

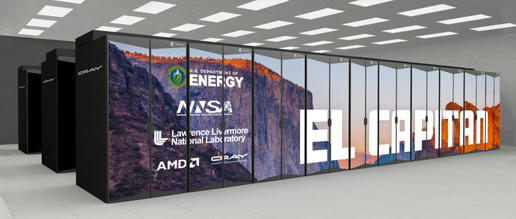

下一代王者“El Capitan”,能否力压气势逼人的AI超算新贵?

就在刚刚过去这一周,劳伦斯利弗莫尔国家实验室正在紧锣密鼓地为其“El Capitan”超级计算机安装组件。如今的问题已经不在于El Capitan能否成为全球最强大的新一代超算系统(已经有照片证明了这一点),而是这顶桂冠在它头顶能保持多久。

专家访谈:聊聊劳伦斯利弗莫尔国家实验室的EL CAPITAN系统与创新架构

近年来,世界各国的HPC大师们正纷纷转向超大规模与云设施领域。但不同于在供应商处任职,他们往往更倾向在自己熟悉的岗位上不断深耕。劳伦斯利弗莫尔国家实验室计算部门的首席技术官Bronis de Supinski就是其中之一。

AI的进一步发展,或将改变超级计算机排名格局?

驱动这波变化的,当然要归功于云系统和AI系统的涌入。两股新势力正令超算排名逐渐偏离其最初目标,在高性能计算(HPC)模拟之外开辟出新的算力厮杀战场。

Arm超级计算机、量子计算 NVIDIA引领HPC的新变革

对于如今的HPC而言,变革势在必行,因为算力的需求永无止境。不管是Arm架构还是量子计算,NVIDIA在引领计算的潮流。

国际高性能计算和人工智能咨询委员会宣布第六届亚太区HPC-AI竞赛正式开赛

第六届亚太区HPC-AI竞赛将持续6个月,比赛结果将在Supercomputing 2023大会上公布,颁奖典礼将在澳大利亚的SupercomputingAsia 2024大会期间举行。

慧与同CCS签署谅解备忘录助其加快云迁移的步伐

慧与公司已经与英国皇家商业服务局(CCS)签署了一份谅解备忘录(MoU),向该公共服务部门提供这家科技巨头旗下GreenLake的建议,并在云端运行其工作负载和应用程序。

ZETTASCALE与量子计算:一条漫长而曲折的发展之路

所有这一切都将回归最初的主题:HPC创新需要大量时间,量子加经典的混合系统可能才是最终解决之道。未来的计算基板可能会以分子、光子甚至是其他未知的形式,工程师和科学家们距离正确答案还非常非常遥远。